Apple Glass – Minden, amit eddig tudunk (2. rész)

Már nagyon várjuk az Apple okos szemüvegét.

Az almás vállalat eddig igen csak szép számokat produkált viselhető eszközök terén, gondoljunk csak az Apple Watch-ra, ami jelenleg is a legnagyobb darabszámban eladott okosóra, illetve óra is a piacon. Az Apple következő nagy dobása minden bizonnyal egy kiterjesztett valóság szemüveg lesz, ami az „Apple Glass” névre hallgathat majd.

Hamarosan elérünk arra a pontra, amikor digitálisan leképezett alakzatok repkednek majd a szemünk előtt, a valós térben, egy okos szemüvegnek hála. A mai cikkünkben körbejárjuk ezt a jövőbe mutató terméket, és megvizsgáljuk, hogy pontosan mire is számíthatunk, ha megvásárolunk majd egy ilyen eszközt. Az alábbi pontokban összeszedtük számotokra, hogy mik lesznek a főbb sarokkövei ennek a kiterjesztett valóság szemüvegnek.

- 2022-es megjelenés

- Műanyag vagy fém ház

- Információ kivetítése mindkét lencsére

- Használathoz szükséges iPhone

- Kamerák nélkül, csak LiDAR szenzorral

- Stílusos, nem „kockás” megjelenés

- Gesztusvezérlés

- Vényköteles lencse opció

- Árazás: 150 000 Ft-tól

Az Apple Glass és a Biztonság

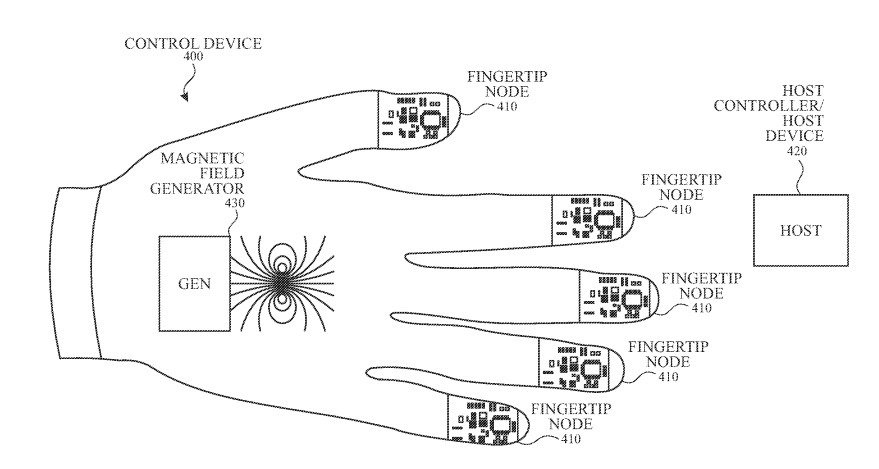

Az Apple szinte biztos, hogy lehagyja a kameraszenzort az okos szemüvegéről, érthető okok miatt, hiszen ez az eszköz akár egész nap rajtunk lehet, reggeltől estig, ami számos magánéleti aspektust takar, ezeket pedig nem biztos, hogy egy kamera elé szeretnénk tárni. Jon Prosser szerint az Apple csak olyan szenzorokat fog használni a szemüvegén, mint a LiDAR, amit megtalálunk az újabb iPad Pro modelleken és az iPhone 12 Pro szérián is. Ez a környezet feltérképezésében segít majd az eszköznek, illetve a gesztusvezérlést is ez teszi lehetővé, hiszen felismer majd bizonyos kézmozdulatokat.

Az Apple termékei között mindig is akadt átfedés, kamera téren viszont mindig az iPhone volt a befutó, és ez ezentúl sem valószínű, hogy változni fog. A Google Glass ezzel szemben megpróbálta felváltani a telefonunkat, míg az Apple oldalán ez inkább egy kiegészítő lenne, ami hozzáad a felhasználói élményhez.

Emellett arra is figyel majd a cég, hogy a kíváncsi szemeknek se essünk áldozatul, ugyanis az Apple Glass által kivetített képet csak a viselő láthatja majd, még egy mellettünk a járdán elhaladó gyalogos sem tud majd belekukkantani az éppen végzett tevékenységünkbe.

Az almás szemüveg segíthet majd nekünk abban is, hogy azonosítsuk magunkat más eszközök feloldásához. Itt az eszköz az iPhone biometrikus azonosítása helyett érzékelheti azt hogy éppen belenézünk a szemüvegbe, és így oldaná fel a mobilt, ami még gyorsabbá tenné a folyamatot. Természetesen a funkció csak akkor működne, ha a viselő már azonosította magát a szemüveg számára, ahogyan az Apple Watch esetében is.

Starboard – avagy a felhasználói felület közelebbről

Az iPhone a Springboard-ot használja, mint interfész, itt látjuk az ikonokat, amik a kezdőképernyőt képezik. Az Apple Glass felülete pedig a „Starboard” nevet kaphatja, amiről egyelőre még nincsen lényegesebb kiszivárgott információnk.

Kisebb jeleket már ugyan találtak a rendszer létezésére, egészen pontosan az iOS 13-ban, itt egy StarTester kódra bukkant néhány figyelmes felhasználó, ami egy „viselhető vagy kézbefogható” eszközről szól. Ahogyan azt korábban is említettük, az Apple LiDAR szenzorok segítségével ismeri majd fel a gesztusainkat, amikkel vezérelhetjük majd az eszközt. Pár szabadalomban viszont szó esett egy különálló kontrollerről is, ami még interaktívabbá tehetné az eszköz használatát, például játékok esetében.

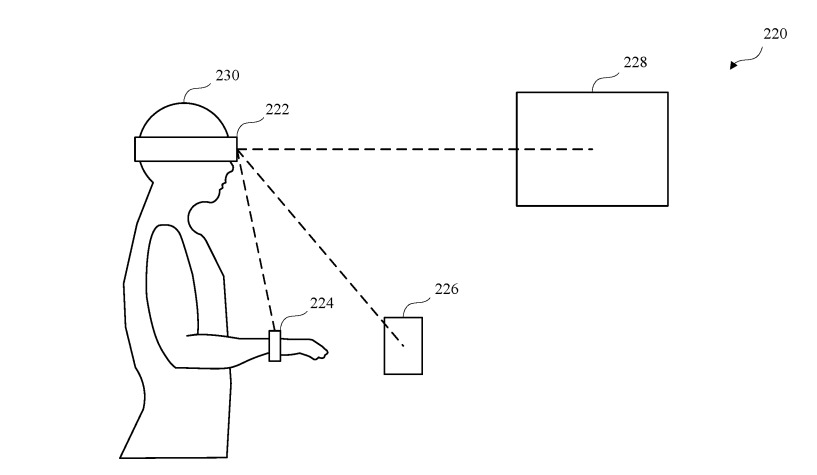

Az első generációs modell esetében persze a legtöbb „élmény” passzív lesz, akárcsak a felugró iMessage üzenetek, útvonaltervek, hely ajánlások és így tovább. Ennek az élménynek a létrehozásában nem fog szerepet játszani kamera, azonban a LiDAR szenzor, a geolokáció, az iránytű, a fej dőlésszöge, a szem követés és egyéb szenzorok is segítenek majd az AR objektumok valós térben történő elhelyezésében. A kivetítés pozíciójának meghatározásában segíthet majd az iPhone-unk, vagy az Apple Watch-unk is, amik viszonyítási pontként tudnak majd szolgálni a szemüveg számára.

AR funkciók az iOS 14-ben

Az Apple idén júniusban is megtartotta a WWDC-t, vagyis az éves fejlesztői konferenciáját, ahol megtudhattuk, hogy mire számítsunk az egyes platformoktól és szoftverektől. A 2021-es év hozta a legtöbb információt azt illetően, hogy mire is számíthatunk majd a jövőben megjelenő Apple Glass-tól.

ARKit 4

A programban lévő helyzet sarokpontok lehetővé teszik majd a fejlesztők és felhasználók számára, hogy virtuális tárgyakat helyezzenek el a valós térben, illetve, hogy az ott is maradjon, a sarokponthoz rögzítve. Egy AR szemüveg esetében ezek az objektumok már különösebb interakció nélkül is meg tudnának jelenni a felhasználó szeme előtt, térkép és egyéb adatok alapján.

Az új Depth API azzal a céllal lett létrehozva, hogy hasznát vegye a negyedik generációs iPad-ben is lévő LiDAR szenzornak. Ennek segítségével a felhasználók 3D-s modelleket készíthetnek helyszínekről pár másodperc alatt, ami egy még komolyabb AR élményt eredményez majd.

A kéz és arckövetés szintén az ARKit 4-gyel került be a rendszerbe, ami még komolyabb AR játékélményt és különleges filterek használatát teszi lehetővé. Ennek segítségével akár élőben is fordíthatunk jelnyelvet vagy egyes személyekhez csatolhatunk AR objektumokat játékokban, akár egy lézercsatában is.

Apple Clips

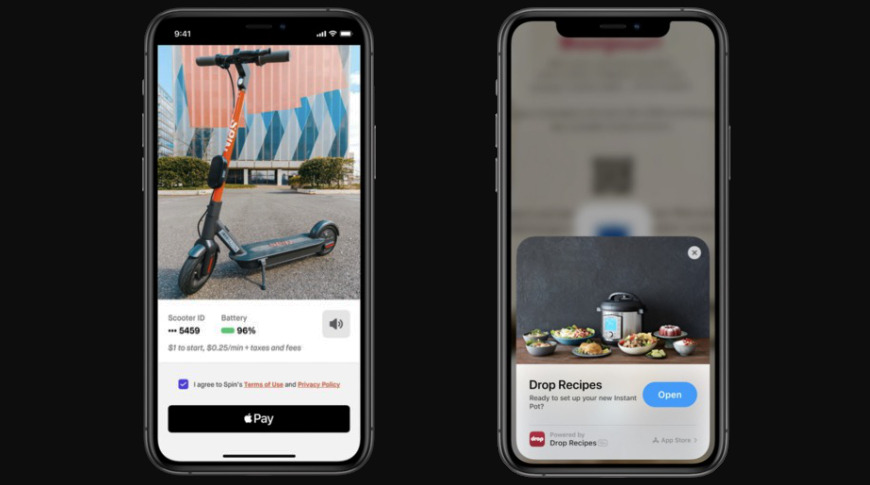

Az említett szoftver segítségével az Apple felhasználók hozzáférhetnek bizonyos alkalmazások egyes funkcióihoz, anélkül, hogy letöltenék őket az App Store-ból.

Az iOS 14-ben a felhasználók már megérinthetnek egy NFC matricát, rákattinthatnak egy linkre, vagy beolvashatnak egy QR kódot ahhoz, hogy hozzáférjenek egy „Clip”-hez. Ezek az App Clip-pek kis méretű verziói egy alkalmazásnak, aminek 10MB alatt kell lennie, ez pedig egy lebegő ablakként fog megjelenni az eszközünkön, ha megtesszük a már említett interakciók egyikét. Ezután használhatjuk is a „Belépés Apple-lel” opciót és az Apple Pay-t, hogy befejezzük a tranzakciónkat, mindössze pár másodperc alatt, anélkül, hogy letöltenénk egy felesleges alkalmazást.

Itt a specifikus QR kódok a legérdekesebbek, ugyanis ezekből egyre több és több lesz az egész világon, amiket beszkennelhetünk az iPhone-unkkal, később pedig az Apple Glass szemüvegünkkel is. Utóbbi esetében elég lenne csak közel sétálni a QR kódhoz, amikor is megláthatnánk egy AR objektumot, amivel interakcióba léphetünk a fizetéshez, az alkalmazás letöltése nélkül.

HomeKit Biztonságos videó Arcfelismerés

A HomeKit Biztonságos videó még 2019-ben lett hozzáadva az iOS-hez, ami lehetővé tette a megjelenő tárgyak felismerését, és azok keresését. Az iOS 14-gyel a biztonsági funkció arcfelismeréssel is bővült, ami felismeri a felhasználót, ha az megközelíti a kamerát. Az Apple Glass ugyan nem használ majd kamerát, a LiDAR viszont szintén hasznos lehet annak a megállapítására, hogy ki is az adott személy.

Itt első sorban megtudhatnánk a személy nevét és alapinformációit, akire éppen ránéztünk. Ez persze számos biztonsági kérdést vet fel, azonban a megjelenített adatok korlátozva lehetnének a felhasználó iPhone-ján lévő információkra.

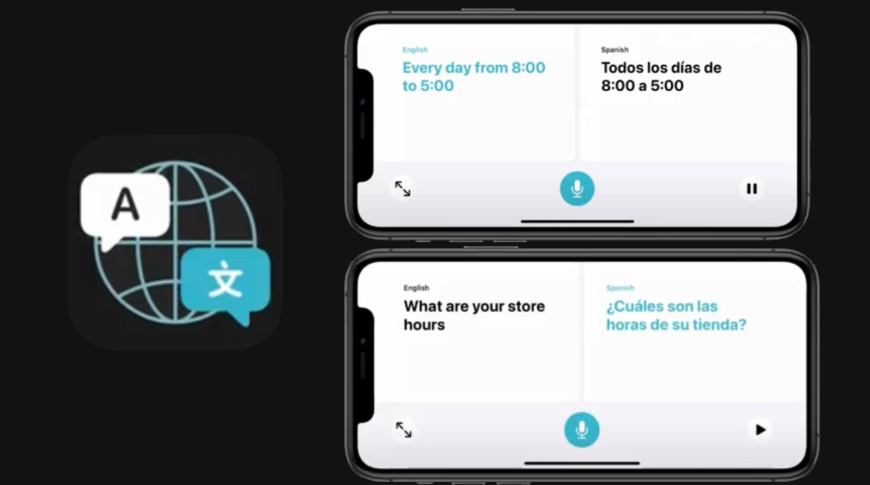

Siri Fordító

Az új Fordító alkalmazás az iOS 14-ben lehetővé teszi Siri-t, hogy akár élőben is fordítson számunkra egy beszélgetés közben. Az app intelligensen felismeri a beszélő által használt nyelvet és menet közben lefordítja azt.

Ahogyan pedig Siri egyre okosabbá válik az élő fordítás és a nyelv felismerés terén, úgy az Apple Glass egyik funkciója lehet majd az élő felirat készítése idegennyelvekhez.

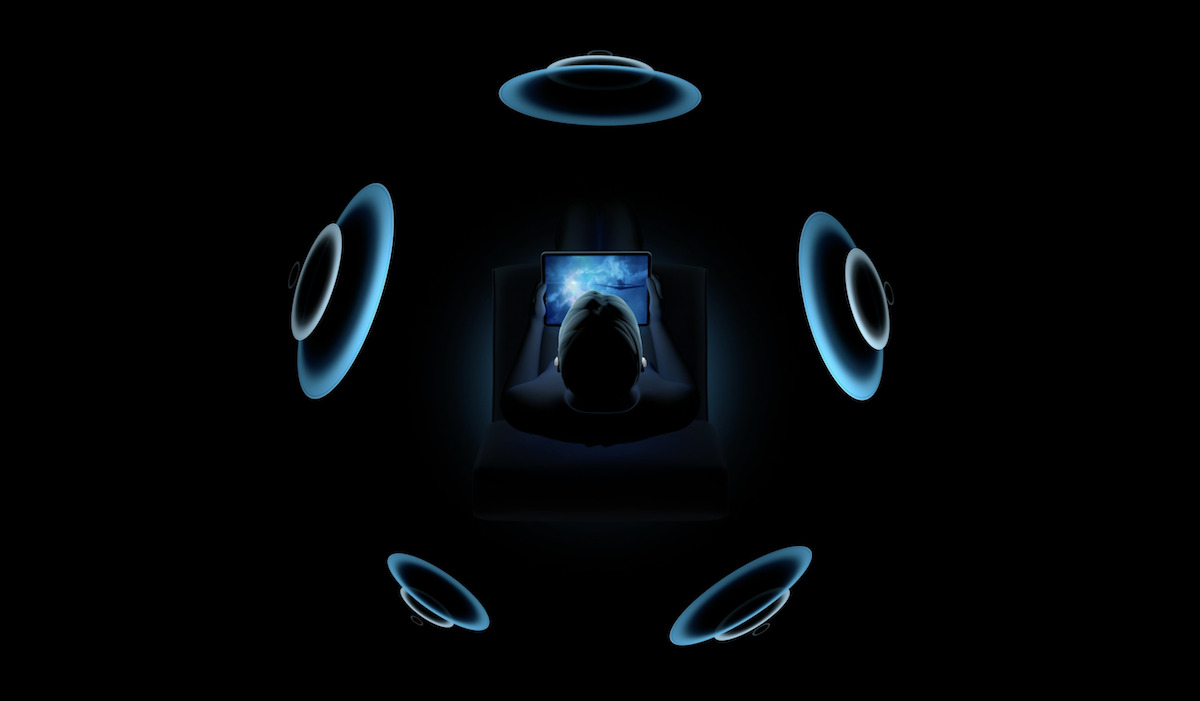

AR Hangzás

Az Apple folyamatosan jelentet meg új funkciókat az eszközeihez, akár megjelenés után is, és nem csak a telefonokhoz vagy tabletekhez. Beszélhetünk itt az AirPods vonalról is, vagy még pontosabban a H1-es chipet használó eszközökről. Ezek az eszközök egy olyan frissítést kaptak, hogy képesek egy adott audiót egy szimulált 3D-s közegben lejátszani, ahol különböző irányokból hallhatjuk a hangokat, ahogyan forgunk a valós térben.

Az eszközön lévő szenzorok segítségével az AirPods képes lesz megváltoztatni a hangélméynt annak függvényében, hogy éppen hogyan fordítjuk, vagy döntjük a fejünket. Ennek segítségével a jövő AR játékai létrehozhatnak egy 3D-s környezetet a felhasználó körül a valós világban, így a játékos meghatározhatja majd az egyes objektumok helyzetét csupán a hangjuk alapján. Például a Pokémon GO-ban a felhasználók megtalálhatnak egy Pokémont az alapján is, hogy éppen honnan hallják.

Apple Glass Árak és Megjelenés

A legnagyobb kiszivárgás az Apple viselhető kütyüjével kapcsolatban 2020 május 18-án érkezett, Jon Prosser-től. Prosser azt állította, hogy az Apple Glass $499-ba (kb.: 150 000 Ft) fog kerülni, plusz a vényköteles lencsék, amennyiben szükségünk van rájuk. Több mint valószínű, hogy ezek a lencsék egyedi darabok lesznek majd, így a végösszes egészen magas is lehet, attól függően, hogy hol csináltatjuk majd őket.

Ming-Chi Kuo szerint az Apple Glass az Apple VR headset után fog megjelenni. Utóbbira 2022 környékén számíthatunk majd, míg a szemüveg egy évvel ezután érkeznek majd. Kuo azt is elárulta, hogy az Apple AR funkciókkal rendelkező kontakt lencséket is bemutat majd 2030 magasságában, persze ez még nagyon hetktikus.

Ne felejtsétek el, hogy ez a kétrészes Apple Glass összefoglaló cikkünk második része, aminek az elejét ezen a linken éritek el, itt beszélünk a funkciókról, a dizájnról, és a hardverről is.

Ti mit gondoltok az Apple Glass-ról, szívesen kipróbálnátok? Írjátok meg nekünk kommentben!

Forrás: appleinsider

Kapcsolódó tartalom:

- iPhone Árak és Vásárlás a HasználtAlmán

- Javíthatja a szemüvegesek látását az Apple Glass

- DJI Osmo Pocket – első benyomások [videó]